클래스 소개

하둡이란?

|

|

하둡은 대용량 데이터를 분산 처리할 수 있는 자바기반의 오픈소스 프레임워크 입니다.

하둡은 구글이 논문으로 발표한 GFS(Google File System) 와 맵리듀스(MapReduce) 를

2005년에 더그커팅(Doug Cutting) 이 구현한 결과물 입니다.

처음에는 오픈소스 검색엔진인 너치(nutch) 에 적용하기 위해 시작했다가

이후 독립적인 프로젝트로 만들어졌고, 2008년에는 아파치 최상위 프로젝트로 승격되었습니다.

하둡은 분산 파일 시스템인 HDFS(Hadoop Distributed File system) 에 데이터를 저장하고

분산 처리 시스템인 멥리듀스를 이용해 데이터를 처리합니다.

하둡은 구글이 논문으로 발표한 GFS(Google File System) 와 맵리듀스(MapReduce) 를

2005년에 더그커팅(Doug Cutting) 이 구현한 결과물 입니다.

처음에는 오픈소스 검색엔진인 너치(nutch) 에 적용하기 위해 시작했다가

이후 독립적인 프로젝트로 만들어졌고, 2008년에는 아파치 최상위 프로젝트로 승격되었습니다.

하둡은 분산 파일 시스템인 HDFS(Hadoop Distributed File system) 에 데이터를 저장하고

분산 처리 시스템인 멥리듀스를 이용해 데이터를 처리합니다.

왜 하둡이 빅데이터에서 가장 주목받게 된것일까요?

오늘날 우리는 엄청나게 많고 다양한 종류의 데이터가 쏟아져 나오는 시대에 살고 있습니다.

이런 다양한 종류의 데이터들중에는 우리가 그동안 한번도 분석해보지 못한 데이터들도 있습니다.

데이터들중 테이블 형태와 같은 정형 데이터의 경우는 기존의 관계형 데이터베이스에 저장할 수 있지만 웹로그 같은 비정형 데이터를 RDBMS 에 저장하기에는 적합하지 않고 그 양이 너무 큽니다.

사용 RDBMS 가 설치되는 곳은 대부분 고가의 장비인데다가

데이터를 감당하기 위해 무한정 스토리지를 늘릴 수도 없는 노릇입니다.

이에 반해 하둡은 오픈소스 프로젝트이기에 소프트웨어 라이센스 비용에 대한 부담이 없습니다.

시스템 운영이나 데이터베이스 관련 업무를 해보신분이라면

상용 RDBMS 의 라이선스 비용이 얼마나 큰지 아실 것입니다.

그런데 하둡은 값비싼 유닉스 장비를 사용하지 않고, x86 cpu 에 리눅스 서버만 있으면 됩니다.

기존 RDBMS 는 데이터 베이스가 설치된 서버 한군데에만 데이터를 저장하는 방식이라면,

하둡은 여러대의 서버에 데이터를 저장할 수 있고

데이터가 저장된 각 서버에서 동시에 데이터를 처리합니다.

이러한 분산 컴퓨팅 방식을 통해 하둡은기존 데이터 분석 방식으로는

상상도 못했던 성과를 보여줬습니다.

2008년 뉴욕타임즈는 130년 분량의 신문기사 1100만 페이지를

아마존 EC2, S2, 하둡을 이용해 하루만에 PDF 로 변환하는데 성공했습니다.

이때 소요된 비용은 200만원에 불가합니다.

이 변환작업은 그 당시 일반 서버로 진행할 경우 약 14년이 소요되는 엄청난 작업량이었습니다.

하둡은 이렇게 저렴한 구축 비용과 비용 대비 빠른 데이터 처리,

그리고 장애를 대비한 특성은 많은 기업들의 구미를 당기게 했습니다.

그래서 초기에 야후에서만 주도적으로 사용됐지만,

현재는 아마존, 이베이, 페이스북, 마이스페이스 등 글로벌 서비스 업체에서 주로 이용하고 있으며,

국내에서는 NHN, DAUM 과 같은 포털기업과 KT, SKT 같은

기관통신사업체와 그외 다수의 기업들에서 사용되고 있습니다.

(강의 참고 서적 - 시작하세요! 하둡 프로그래밍 - 위키북스, 정재화 지음)

이런 다양한 종류의 데이터들중에는 우리가 그동안 한번도 분석해보지 못한 데이터들도 있습니다.

데이터들중 테이블 형태와 같은 정형 데이터의 경우는 기존의 관계형 데이터베이스에 저장할 수 있지만 웹로그 같은 비정형 데이터를 RDBMS 에 저장하기에는 적합하지 않고 그 양이 너무 큽니다.

사용 RDBMS 가 설치되는 곳은 대부분 고가의 장비인데다가

데이터를 감당하기 위해 무한정 스토리지를 늘릴 수도 없는 노릇입니다.

이에 반해 하둡은 오픈소스 프로젝트이기에 소프트웨어 라이센스 비용에 대한 부담이 없습니다.

시스템 운영이나 데이터베이스 관련 업무를 해보신분이라면

상용 RDBMS 의 라이선스 비용이 얼마나 큰지 아실 것입니다.

그런데 하둡은 값비싼 유닉스 장비를 사용하지 않고, x86 cpu 에 리눅스 서버만 있으면 됩니다.

기존 RDBMS 는 데이터 베이스가 설치된 서버 한군데에만 데이터를 저장하는 방식이라면,

하둡은 여러대의 서버에 데이터를 저장할 수 있고

데이터가 저장된 각 서버에서 동시에 데이터를 처리합니다.

이러한 분산 컴퓨팅 방식을 통해 하둡은기존 데이터 분석 방식으로는

상상도 못했던 성과를 보여줬습니다.

2008년 뉴욕타임즈는 130년 분량의 신문기사 1100만 페이지를

아마존 EC2, S2, 하둡을 이용해 하루만에 PDF 로 변환하는데 성공했습니다.

이때 소요된 비용은 200만원에 불가합니다.

이 변환작업은 그 당시 일반 서버로 진행할 경우 약 14년이 소요되는 엄청난 작업량이었습니다.

하둡은 이렇게 저렴한 구축 비용과 비용 대비 빠른 데이터 처리,

그리고 장애를 대비한 특성은 많은 기업들의 구미를 당기게 했습니다.

그래서 초기에 야후에서만 주도적으로 사용됐지만,

현재는 아마존, 이베이, 페이스북, 마이스페이스 등 글로벌 서비스 업체에서 주로 이용하고 있으며,

국내에서는 NHN, DAUM 과 같은 포털기업과 KT, SKT 같은

기관통신사업체와 그외 다수의 기업들에서 사용되고 있습니다.

(강의 참고 서적 - 시작하세요! 하둡 프로그래밍 - 위키북스, 정재화 지음)

교육대상

하둡을 이용하여

하둡을 이용하여

다양한 형태의

데이터 분석을 하려는 분 하둡과 스파크 관리자

하둡과 스파크 관리자

취업을 위해

하둡에 입문하시는 분 리눅스 설치부터

리눅스 설치부터

천천히 따라하며

하둡을 배우고 싶으신분

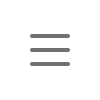

강의 맛보기

리눅스 설치부터 스파크로 데이터 분석까지 한번에 끝!! 하둡 기초 실무초보자를 위한 하둡 입문 강의

수강기간 / 환불정책 안내

- 본 클래스는 117차시, 9시간 40분 분량으로 구성되어 있으며,

일 1시간 내외의 학습 시간을 기준으로 2주(14일) 수강시 완강이 가능한 구성입니다. - 해당 클래스는 사전 공지 없이 콘텐츠 내용, 가격, 할인 정책등이 변동 될 수 있습니다.

(1) 학습 기간

- 기본수강기간(유료수강기간)은 최초 1개월 (30일)이며,

기본수강기간 이후부터는 무제한(무료) 학습 기간이 적용됩니다. (기본 2년, 2년 단위로 무료 연장신청) - 유/무료 수강기간 모두 동일한 환경으로 학습이 가능합니다.

- 수강 시작일(유료 수강기간)은 결제일로부터 기간이 산정되며, 결제를 완료하시면 ‘내 강의실’을 통해 확인 가능합니다.

- 이지업클래스의 사정으로 인해 수강 시작이 늦어진 경우에는 해당 일정 만큼의 수강기간이 연장됩니다.

(2) 환불 규정

- 이지업클래스의 환불규정은 아래와 같습니다.

* 전액환불- 수강 시작 후 14일 이내, 5차시 & 5%(시간) 미만 수강 시

- 수강 시작 후 14일 이내, 10차시 & 10% 미만 시간 수강시: 실 결제금액의 2/3을 환불

- 수강 시작 후 14일 이내, 15차시 & 15% 미만 수강시: 실 결제금액의 1/3을 환불

- 요청일 기준 수강 시작 후 15일 초과 또는 15차시 또는 15% 이상 수강시 : 환불금액 없음

(3) 주의 사항

- 본 강의는 상황에 따라 사전 공지나 안내 없이 할인이 조기 마감 또는 연장 될 수 있습니다.

- 천재지변, 폐업 등 서비스 중단이 불가피한 상황에는 사전 안내 없이 종료될 수 있습니다.

- 무제한 강의의 경우, 내 강의실 수강기간 연장 신청을 통해 무제한으로 연장 가능합니다.

- 구매한 무제한 강의의 연장 진행을 하지 않아 종료될 경우 복구되지 않습니다.

- 강의 컨텐츠는 향후 이지업클래스의 사정에 따라 추가 또는 업데이트 될 수 있습니다

이 강의를 담당하시는 강사님을 소개합니다

유연수

유연수: 이지업클래스의 대표 강사님이 직접 운영하시는 강의 입니다.

: SQL과 SQL튜닝을 체계적으로 학습하고 활용할 수 있도록 제공해드립니다.

: 다양한 경험과 프로젝트 실무를 바탕으로 후학을 양성중인 DB전문가 이십니다.

‘안녕하세요. 유연수 강사 입니다.’

이지업클래스의 대표 강사님 이신 유연수 강사님은 지난 25년간 SK telecom, KT, 건강보험 심사평가원, 우정사업본부, 한국 오라클 교육센터에서 활동하며 쌓은 경험을 활용하여 인재 양성에 힘써주고 계시며, 현재 강남 아이티윌에서 오라클 DBA 전문가반을 양성하고 있습니다.

: SQL과 SQL튜닝을 체계적으로 학습하고 활용할 수 있도록 제공해드립니다.

: 다양한 경험과 프로젝트 실무를 바탕으로 후학을 양성중인 DB전문가 이십니다.

‘안녕하세요. 유연수 강사 입니다.’

이지업클래스의 대표 강사님 이신 유연수 강사님은 지난 25년간 SK telecom, KT, 건강보험 심사평가원, 우정사업본부, 한국 오라클 교육센터에서 활동하며 쌓은 경험을 활용하여 인재 양성에 힘써주고 계시며, 현재 강남 아이티윌에서 오라클 DBA 전문가반을 양성하고 있습니다.

주요 이력

- (현) 강남 아이티윌 데이터 분석가 / 딥러닝 개발자 과정 운영- (현) 이지업클래스 대표 강사

- SK 텔레콤, KT, 건강보험 심사평가원, 우정사업본부, 한국 오라클 교육센터 등 다수 프로젝트 역임

보유 자격

- 빅데이터 분석 기사 자격증 (2021년)- OCM- DBA 11G

- OCM- DBA 10G

- OCP-DBA 10G

- OCP-DBA 9i

- OCP-DBA 8

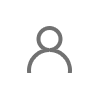

커리큘럼

| Hadoop 과정 소개 | |

| [인트로1] 하둡과 스파크100제 강사소개 | |

| [인트로2] 하둡과 스파크 수업 소개 | |

| [인트로3] 가상화란 무엇인가 | |

| Chapter 1 - 환경 구성 | |

| 예제01 가상환경 만들기 | |

| 예제02-1 가상환경에 리눅스 설치 | |

| 예제02-2 예제2번 설치 뒷부분 | |

| 예제03 게스트 확장 cd 삽입 | |

| 예제04 윈도우와 복사붙여넣기를 자유롭게 | |

| 예제05 리눅스 시스템에서 인터넷 연결하는 방법 | |

| 예제06 putty 를 이용해서 리눅스 서버에 접속하기 | |

| Chapter 2 - Linux | |

| 예제07 리눅스 기본명령어1 - cd | |

| 예제08 리눅스 기본명령어2 - touch | |

| 예제09 putty 로 접속과 설정을 편하게 하는 방법 | |

| 예제10 리눅스 기본 명령어3 - mkdir | |

| 예제11 리눅스 기본 명령어4 - rm | |

| 예제12 리눅스 기본 명령어5 - rmdir | |

| 예제13 리눅스 기본 명령어6 - alias | |

| 예제14 리눅스 기본 명령어7 - cat | |

| 예제15 리눅스 기본 명령어8 - redirection | |

| 예제16 리눅스 기본 명령어9 - more | |

| 예제17 리눅스 기본 명령어10 - head | |

| 예제18 리눅스 기본 명령어11 - wc | |

| 예제19 리눅스 기본 명령어12 - grep | |

| 예제20 리눅스 기본 명령어13 - awk | |

| 예제21 리눅스 기본 명령어14 - sort | |

| 예제22 리눅스 기본 명령어15 - uniq | |

| 예제23 리눅스 기본 명령어16 - awk -F | |

| 예제24 리눅스 기본 명령어17 - diff | |

| 예제25 리눅스 기본 명령어18 - find | |

| 예제26 리눅스 기본 명령어19 - tar | |

| 예제27 리눅스 기본 명령어20 - sed | |

| 예제28 리눅스 기본 명령어21 - cp | |

| 예제29 리눅스 기본 명령어22 - mv | |

| 예제30 리눅스 기본 명령어23 - chown | |

| 예제31 리눅스 기본 명령어24 - chmod | |

| 예제32 리눅스 기본 명령어25 - useradd | |

| 예제33 리눅스 기본 명령어26 - top | |

| 예제34 리눅스 기본 명령어27 - ps | |

| Chapter 3 - vi 편집기 | |

| 예제35 vi 편집기 명령어1 - command모드 | |

| 예제36 vi 편집기 명령어2 - edit모드 | |

| 예제37 vi 편집기 명령어3 - last line모드 | |

| 예제38 vi 편집기 명령어4 - vi 편집기 내에서 커서 이동 | |

| 예제39 vi 편집기 명령어5 - vi 편집기의 삭제 명령어 | |

| 예제40 vi 편집기 명령어6 - vi 편집기의 복사붙여넣기 명령어 | |

| 예제41 vi 편집기 명령어7 - vi 편집기 내에서 특정 문자를 검색하는 방법 | |

| Chapter 4 - Hadoop | |

| 예제42 하둡소개 | |

| 예제43 하둡 생태계구조 살펴보기 | |

| 예제44 하둡 구성도 살펴보기 | |

| 예제45-01 하둡설치1 - 설치프로그램 다운로드 받기1 | |

| 예제45-02 하둡설치2 - 설치프로그램 다운로드 받기2 | |

| 예제45-03 하둡설치3 - 인터넷이 되는지 확인 | |

| 예제45-04 하둡설치4 - 아이피주소 3개 확인 | |

| 예제45-05 하둡설치5 - 네트워크 리스타트 | |

| 예제45-06 하둡설치6 - 방화벽 해제 및 ld-linux | |

| 예제45-07-1 하둡설치7 - protoc 설치 | |

| 예제45-07-2 하둡설치7 - 자바설치 | |

| 예제45-08 하둡설치8 - 키젠생성 | |

| 예제45-09 하둡설치9 - 하둡설치파일 옮기기 | |

| 예제45-10 하둡설치10 - 하둡 홈디렉토리 지정하기 | |

| 예제45-11 하둡설치11 - 하둡 환경설정파일 변경 및 시작 | |

| 예제46 하둡 분산 파일 시스템 명령어1 - put | |

| 예제47 하둡 분산 파일 시스템 명령어2 - lsr | |

| 예제48 하둡 분산 파일 시스템 명령어3 - cat | |

| 예제49 하둡 분산 파일 시스템 명령어4 - du | |

| 예제50 하둡 분산 파일 시스템 명령어5 - get | |

| 예제51 하둡 분산 파일 시스템 명령어6 - mkdir | |

| 예제52 하둡 분산 파일 시스템 명령어7 - rmr | |

| 예제53 하둡 분산 파일 시스템 명령어8 - grep | |

| 예제54 하둡 분산 파일 시스템 명령어9 - awk | |

| 예제55 하둡 분산 파일 시스템 명령어10 - count | |

| Chapter 5 - Hive | |

| 예제56 hive란 | |

| 예제57-01 hive 설치1 - 설치파일 다운로드 | |

| 예제57-02 hive 설치2 - 설치파일 압축풀기 | |

| 예제57-03 hive 설치3 - hive에 접속하기 | |

| 예제58 hive에서 테이블 생성하기 | |

| 예제59 hive에서 문자 데이터 검색하기 | |

| 예제60 hive에서 숫자 데이터 검색하기 | |

| 예제61 hive에서 날짜 데이터 검색하기 | |

| 예제62 hive에서 데이터 정렬하기 | |

| 예제63 hive에서 그룹함수 사용하기1 - max | |

| 예제64 hive에서 그룹함수 사용하기2 - min | |

| 예제65 hive에서 그룹함수 사용하기3 - avg | |

| 예제66 hive에서 그룹함수 사용하기4 - sum | |

| 예제67 hive에서 그룹함수 사용하기5 - count | |

| 예제68 hive에서 그룹함수 사용하기6 - sum+case | |

| 예제69 hive에서 그룹함수 사용하기7 - with rollup | |

| 예제70 hive에서 데이터 분석 함수 다루기1 - rank | |

| 예제71 hive에서 데이터 분석 함수 다루기2 - ntile | |

| 예제72 hive에서 데이터 분석 함수 다루기3 - concat_ws | |

| 예제73 hive에서 테이블 조인하기1 - on 절을 사용한 조인 | |

| 예제74 hive에서 테이블 조인하기2 - outer join | |

| Chapter 6 - Spark | |

| 예제75 스파크 소개하기 | |

| 예제76 스파크 설치하기 | |

| 예제77 스파크에 테이블 생성하기 | |

| 예제78 스파크에서 문자 데이터 검색하기 | |

| 예제79 스파크에서 숫자 데이터 검색하기 | |

| 예제80 스파크에서 날짜 데이터 검색하기 | |

| 예제81 스파크에서 데이터 정렬하기 | |

| 예제82 스파크에서 그룹함수 사용하기 | |

| 예제83 스파크에 데이터 분석함수 사용하기 | |

| 예제84 스파크에서 조인문 사용하기 | |

| 예제85 스파크에서 서브쿼리문 사용하기 | |

| 예제86 스파크에서 검색한 결과를 csv 파일로 생성하기 | |

| Chapter 7 - MongoDB | |

| 예제87 몽고디비 소개와 설치 | |

| 예제88 csv 파일을 몽고디비로 입력하기 | |

| 예제89 하둡 파일 시스템에 있는 csv 파일을 몽고 디비의 테이블로 생성하기 | |

| 예제90 몽고디비에서 문자 데이터 검색하기 | |

| 예제91 몽고디비에서 숫자 데이터 검색하기 | |

| 예제92 몽고디비에서 날짜 데이터 검색하기 | |

| 예제93 몽고디비에서 데이터 정렬하기 | |

| 예제94 몽고디비에서 논리 연산자 사용하기 - and | |

| 예제95 몽고디비에서 논리 연산자 사용하기 - or | |

| 예제96 몽고디비에서 논리 연산자 사용하기 - not | |

| 예제97 몽고디비에서 데이터 중복 제거하기 | |

| 예제98 몽고디비에서 검색한 결과를 csv 파일로 내리기 | |

| 예제99 몽고디비에서 group 함수 사용하기1 | |

| 예제100 몽고디비에서 group함수 사용하기2 |